2021年10月13日下午,由深圳市科学技术协会、哈尔滨工业大学(深圳)主办,深圳市人工智能学会承办,深圳市人工智能学会自然语言处理专委会协办的“自然语言处理青年精英论坛”在哈尔滨工业大学(深圳)圆满召开。

人工智能作为新一轮科技革命和产业变革的重要驱动力量,正在深刻改变世界。而自然语言处理既是人工智能的核心技术,又是计算机科学和语言科学的交叉学科。它推动着语言智能的持续发展和突破,并越来越多地应用于各个行业。大数据、机器学习、深度学习和知识图谱等技术的发展,正在给自然语言处理的发展带来突破。为此,深圳市人工智能学会自然语言处理专委会徐睿峰教授特地策划本次自然语言处理青年精英论坛活动,,邀请自然语言处理领域的青年精英和科研人员共同探讨领域发展趋势、存在问题和突破可能。本次论坛吸引了60余人现场参会和1400余人网上参会。

深圳市人工智能学会理事、自然语言理解专委会主任、哈尔滨工业大学(深圳)徐睿峰教授为本次论坛致辞。他首先向与会人员介绍了深圳市科学技术协会的情况,而后详细介绍了深圳市人工智能学会发起成立和发展现状,以及学会和各专委会的活动。他鼓励大家多关注和参加深圳市人工智能学会组织的各项活动。

哈尔滨工业大学(深圳)徐睿峰教授 开场致辞

本次论坛由哈尔滨工业大学(深圳)汤步洲副教授主持。本次会议邀请三位重量级讲者,分别为清华大学深圳国际研究生院郑海涛副教授,腾讯资深研究员王龙跃博士和哈尔滨工业大学(深圳)助理教授户保田老师,本次论坛由汤步洲副教授主持。汤步洲副教授表示很高兴能为这次会议主持,通过这个平台与各位学者和研究人员进行深入交流沟通。

哈尔滨工业大学(深圳)汤步洲副教授 担任论坛主持

第一位演讲者是来自清华大学深圳国际研究生院的郑海涛副教授。他带来《面向知识挖掘的提示学习方法研究》报告,介绍了在自然语言领域非常热门的提示学习的发展现状、研究趋势以及在知识挖掘中的应用,特别是介绍了其科研团队近期将提示学习应用于细粒度实体分类的研究工作。提示学习是一种新型的深度学习方式,该方法探究如何通过完形填空式的提示文本,在下游任务中充分利用预训练语言模型对语言特征的学习与建模知识。郑海涛团队将提示学习应用于细粒度实体分类任务,提出了简单高效的训练模型,并在全监督、少样本以及零样本场景下较传统微调模型均取得了优异的性能提升。

清华大学深圳国际研究生院郑海涛副教授

第二位演讲者是来自腾讯AI Lab的资深研究员王龙跃博士。他带来《更好更快的神经网络机器翻译系统》报告。王博士指出翻译系统的精度和速度是关乎用户体验的核心问题。精度“更好”要求译文在篇章级别上具备连贯性、衔接性和一致性,而速度“更快”旨在降低大模型的解码延迟和计算资源。在演讲中,王博士系统地介绍了团队在篇章翻译和非自回归翻译方向上的研究工作成果和最新进展。一方面,通过隐性和显性地引入篇章信息打破了传统的句子级翻译系统的建模方式,还极大缓解了零指代语言现象在翻译中的消极影响。另一方面,从训练方法入手改进非自回归模型,有效缓解了低频词的词汇选择问题,在保持加速效果的同时使非自回归模型性能超过自回归方法。最后,王博士结合AI Lab最新落地的网文翻译系统、WMT国际机器翻译大赛等具体场景,向大家展示了相关问题的必要性和提出方法的有效性。

腾讯AI Lab 王龙跃博士

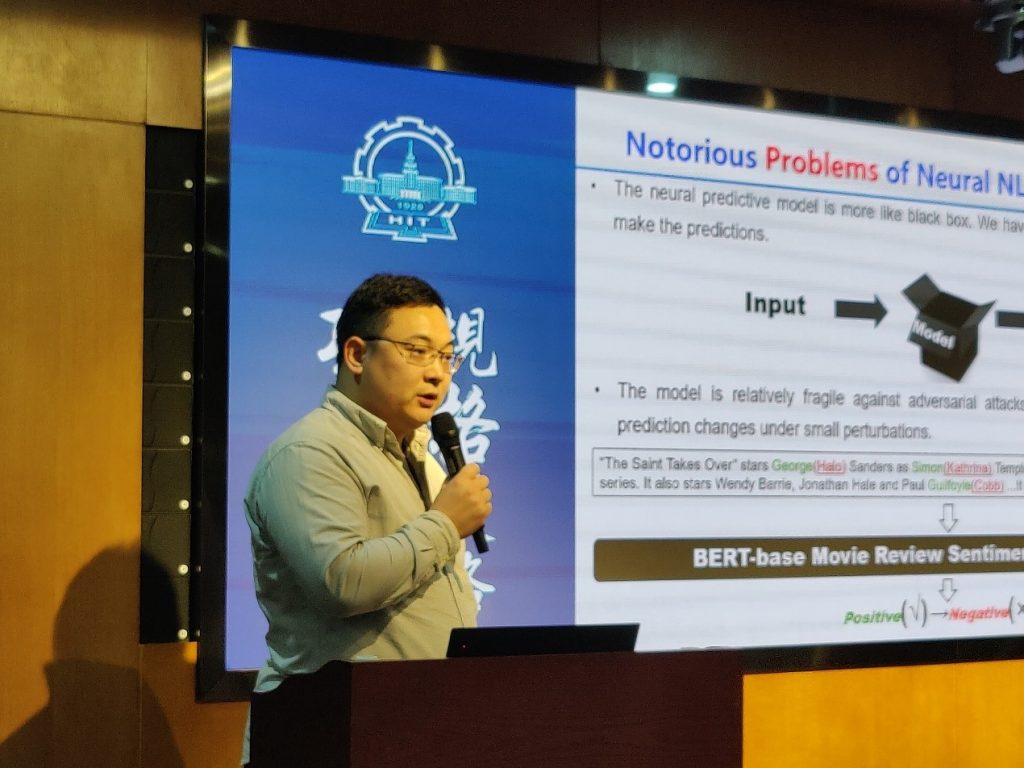

第三位演讲者是来自哈尔滨工业大学(深圳)的助理教授户保田老师,他带来《面向可解释鲁棒的自然语言分类模型研究》报告。户老师针对当前基于深度学习的自然语言分类模型的可解释性差,鲁棒性低的问题,从三个方面介绍了其课题组的相关工作和成果,包括通过融合结构化知识和非结构化文本联合学习的医学阅读模型;具有解释生成能力的文本分类方法;融合混合对抗训练和证据边界约束的鲁棒性、可解释的分类模型。

哈尔滨工业大学(深圳)助理教授 户保田博士

随后,由汤步洲老师主持下,四位专家学者与场内观众进行了现场交流和讨论。大家畅所欲言,各抒己见,在观点碰撞、智慧对话的轻松氛围中解答了这些困惑,现场参会人员受益匪浅。

现场观众提问

郑海涛教授发言

论坛讲者和组织者合影留念

撰稿:SAAI自然语言处理专委会

校对:张丽萍

关注微信公众号

关注微信公众号